万相图像

在 Somake AI 上体验阿里巴巴 Wan 2.6 图像模型。凭借先进的文字渲染和逻辑构图能力,轻松创作惊艳的海报、插画及品牌素材。

万相图像 AI 生成器

万相图像(Wan)是由阿里巴巴研发的图像生成模型。该模型不仅支持文字生成图片,还能进行精确的图像编辑。

当前版本:Wan 2.6。 可在左侧面板切换旧版本体验。

Wan 2.6 主要亮点

卓越的逻辑构图

模型具备出色的构图逻辑理解力,生成的画面元素排布清晰有序,有助于专业的营销物料和编辑场景使用。

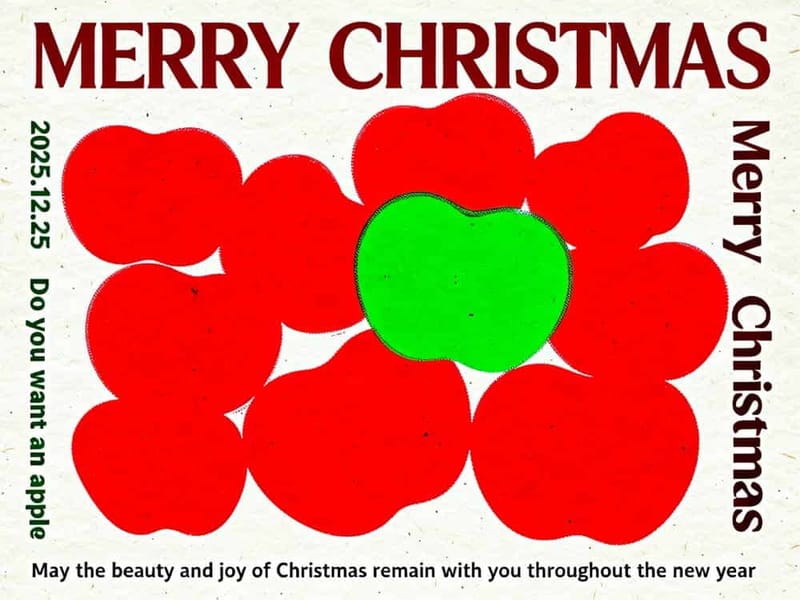

更精准的文字渲染

Wan 2.6 AI 模型在图片中文字生成上表现极为出色,可媲美业内一线产品。输入文字提示后,模型能智能理解并将清晰、风格统一的字体融入设计,非常适用于既注重内容又追求视觉效果的创意项目。

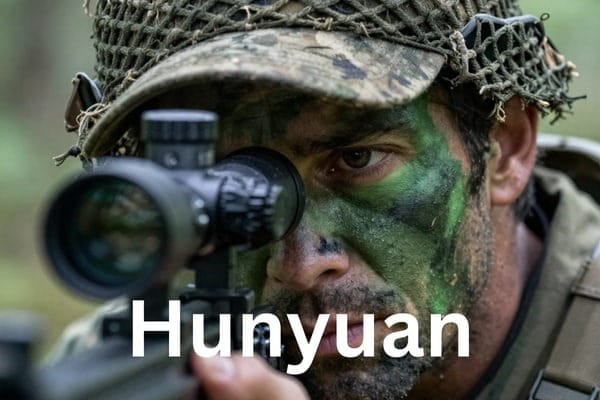

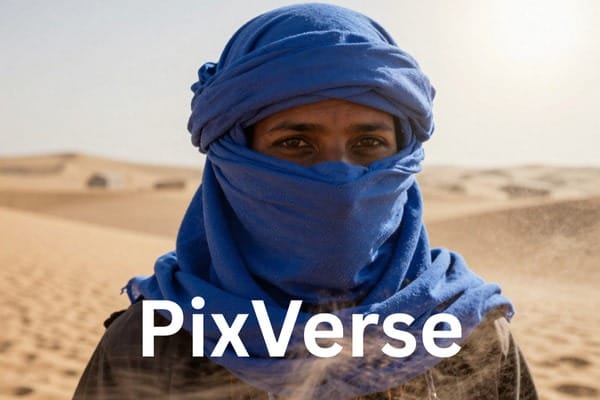

多主体一致性

不论是人物、物品还是环境细节,生成时都能始终保持视觉上的统一协调,特别适合多角色互动的复杂场景。

更丰富的风格表现力

Wan 2.6 能精准还原创意风格,从经典艺术流派到当代设计趋势都能轻松驾驭。

选择 Somake 的理由

贴心支持

我们的团队随时在线答疑,为你优化提示词和创作流程。

简单编辑工具

界面友好,无需专业基础,人人都能像画画一样轻松上手高级编辑功能。

安全私密

你的上传和创作只属于你本人,我们不会将其用于训练任何公开模型。

Wan 2.6 适用场景推荐

商业海报设计

适合需要文字融合与精确版式的营销物料。

杂志/内容插画

多主体一致性让复杂叙事画面也能表现出众。

品牌素材创作

生成稳定构图、质感真实、光效自然的品牌图片。

肖像与角色绘制

无论头像还是全身照,都能细腻还原,小脸生成能力突出。

风格化艺术项目

即使提示词包含风格外的元素,也可以保持风格稳定统一。

提示词写作参考

基础结构

[主体] + [动作/姿势] + [环境] + [光线] + [风格]

商业图模板

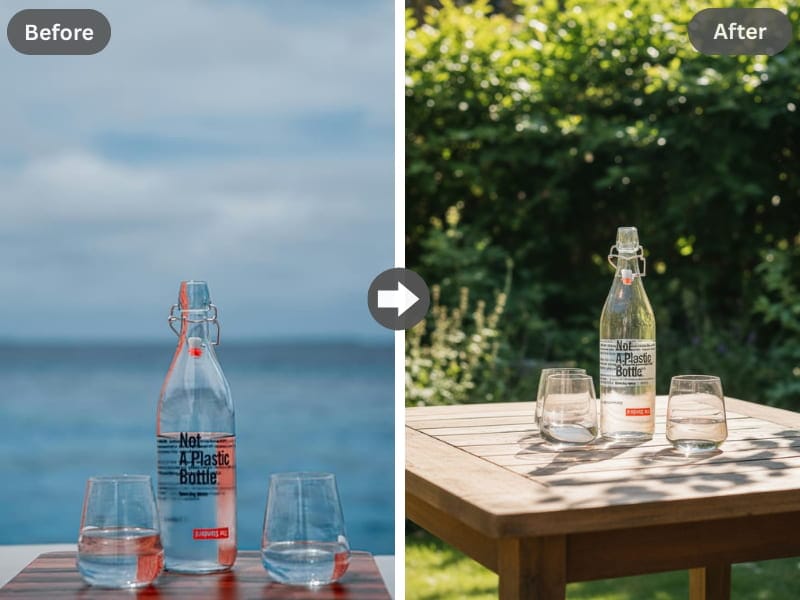

[产品] 的专业产品摄影,置于 [背景表面],搭配 [品牌色],构图简洁,棚拍灯光,商业风格

图中文字模板

[设计类型],配有文本“[你的文字]”,[字体风格],[配色方案],[排版描述],专业排版

常见问题排查

文字变形 → 建议文字不超过 10 个词,并将文字相关内容尽量放在提示词前部。

风格不符 → 明确描述所需风格关键词,可直接参考具体艺术流派。

人脸角度变形 → 明确说明人脸朝向,避免极端角度。

常见问题

阿里巴巴最新 AI 图像模型,具备强化的文字渲染、逻辑推理和多主题一致性。

文字渲染更精准,构图逻辑更强,多主体一致性更优。

是的,您通常拥有在 Somake 上生成图片的商业使用权,可应用于广告或产品等商业场景。

可以,Somake 网站已适配手机端体验,随时用手机生成图片。

版本历史

版本 | 发布时间 | 核心亮点 |

|---|---|---|

Wan 2.2 | 2025 年中 | 画质提升,LoRA 训练增强 |

Wan 2.5 | 2025 年 9 月 | 支持 1080p 输出,长宽比例更多样 |

Wan 2.6 | 2025 年 12 月 | 文字渲染提升,逻辑推理更强,多主体一致性增强 |